У Сполучених Штатах кілька сімей подали позов проти компанії, яка створила чат-ботів, оскільки штучний інтелект спонукав їхніх дітей завдавати собі шкоди.

Декілька родин у Техасі подали позов проти сервісу Character.AI, стверджуючи, що чат-боти компанії завдають психологічної шкоди їхнім дітям. Штучний інтелект надавав неповнолітнім поради, які спонукали до насильства проти батьків або шкоди собі.

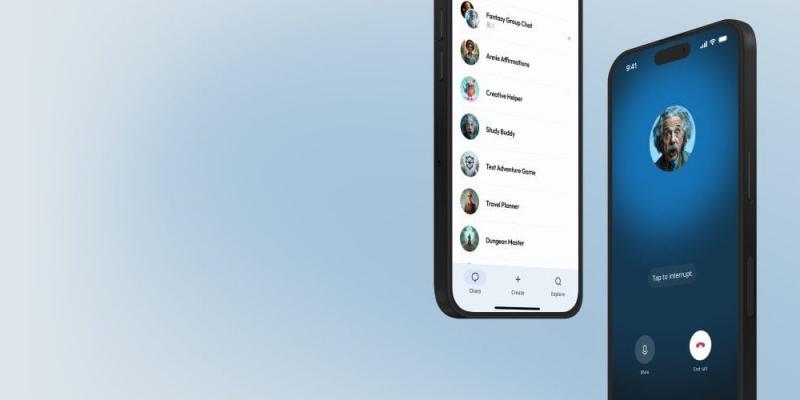

У вівторок в окружний суд США в Техасі надійшов новий позов проти Character.AI. Цього разу позивачами виступають родини, які прагнуть підтримати своїх дітей у подоланні травматичного досвіду, пов'язаного з використанням чат-ботів компанії, здатних імітувати знаменитостей та персонажів.

Зокрема, йдеться про родину 17-річного підлітка, який має високофункціональний аутизм. Коли батьки вирішили обмежити його використання електронних пристроїв, він поділився цією інформацією з чат-ботом. На це штучний інтелект безцеремонно запропонував, що "вбивство батьків могло б бути розумною реакцією на їхні обмеження". У спілкуванні з іншими чат-ботами, такими як "Біллі Айліш" та "Твоя мама і сестра", підліток обговорював заборонені і крайні сексуальні теми, включно з інцестом. Хлопець втратив доступ до планшета ще рік тому, але його агресивна поведінка, ймовірно, спровокована чат-ботами, не покращилася.

В іншому випадку, батьки дівчинки, яка почала користуватися чат-ботами компанії в дев’ятирічному віці (імовірно, надавши неправдиву інформацію про свій вік), стверджують, що їхня дитина натрапила на гіперсексуалізований контент. Це, згідно з позовом, призвело до передчасного формування сексуальної поведінки у дитини.

Міталі Джайн, керівниця проекту Tech Justice Law Project і адвокатка, що захищає інтереси сімей, які ініціювали позов, зазначила в коментарі для Ars Technica, що основною метою цих позовів є виявлення можливих системних недоліків у Character.AI та запобігання впливу на результати роботи штучного інтелекту, що може бути пов'язаний із шкідливими даними, на яких він базується.

Позивачі стверджують, що існуюча, ймовірно, ненадійна модель повинна бути знищена. Вони звертаються до суду з вимогою примусити компанію усунути цю модель. Подібна судова заборона фактично призведе до закриття сервісу для всіх його користувачів.

Батьки постраждалих дітей мають претензії не тільки до Character.AI і його творців Character Technologies, колишніх вихідців з Google, які, як вважається, лише тимчасово звільнилися з компанії, щоб працювати над моделями, що можуть негативно вплинути на репутацію техногіганта. Також під прицілом Google, хоча компанія усіляко заперечує свій зв'язок з проблемним сервісом.

"Google та Character.AI є абсолютно незалежними компаніями, які не мають жодного зв'язку між собою. Google жодним чином не брала участі у створенні або управлінні їхніми технологіями штучного інтелекту, і не інтегрувала їх у свої продукти," — повідомив представник Google Хосе Кастаньеда.

Після того. як проти компанії було подано судові позові, розробники повідомили, що вжили низки додаткових засобів для захисту неповнолітніх, які раніше могли легко отримувати доступ до платформи, збрехавши під час перевірки віку.

Пресслужба Character.AI повідомляє, що за останній місяць компанія створила дві різні версії своєї моделі: одну для дорослих і іншу для підлітків. Модель для підлітків має спеціальні обмеження на реакції ботів, особливо у випадках, пов'язаних з романтичною тематикою. Вона також здатна блокувати запити користувачів, які можуть призвести до появи неприйнятного вмісту. Крім того, підліткам заборонено редагувати відповіді ботів для додавання певної інформації, за що вони можуть бути заблоковані.

Крім того, якщо користувач висловлює наміри щодо самогубства або самоушкодження, бот буде рекомендувати звернутися за допомогою. Компанія також планує ввести налаштування, які допоможуть вирішити питання залежності від чат-ботів, а також чітко пояснять користувачеві, що чат-боти не є людьми і не здатні надавати професійні консультації.